后训练时代如何延续Scaling Law?这是你该读的LLM后训练综述

后训练时代如何延续Scaling Law?这是你该读的LLM后训练综述现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。

让大模型进入多模态模式,从而能够有效感知世界,是最近 AI 领域里人们一直的探索目标。

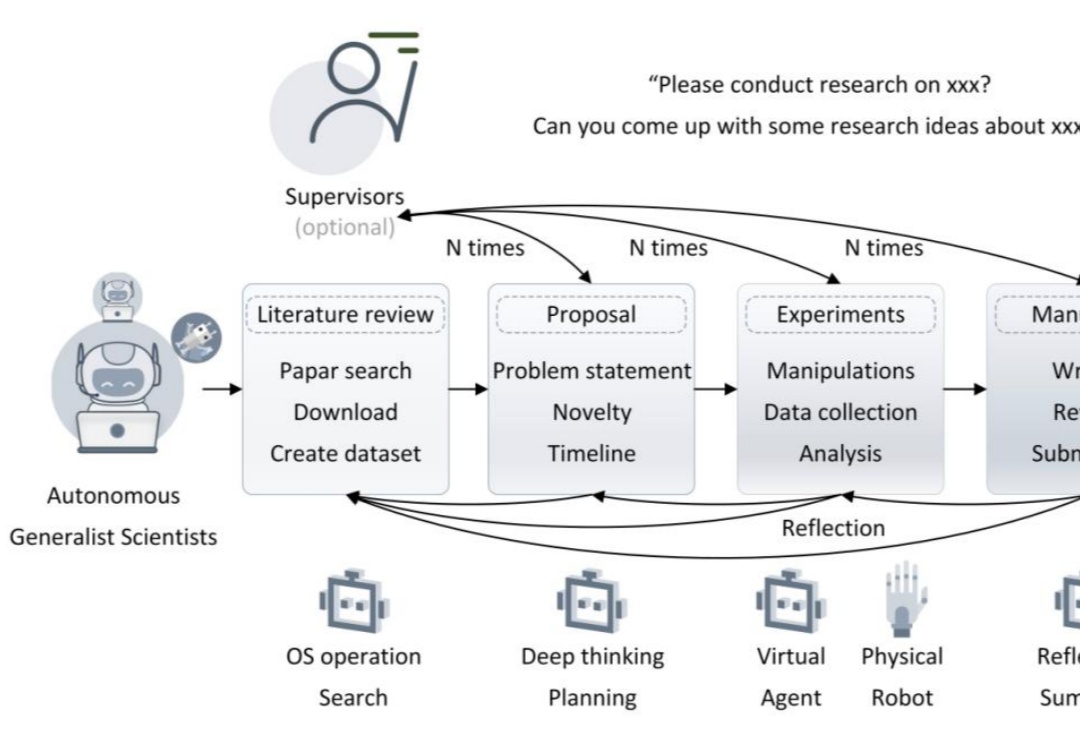

自主通才科学家的 5 个层级。

AI Agent 领域也存在 scaling law,甚至还在加速。

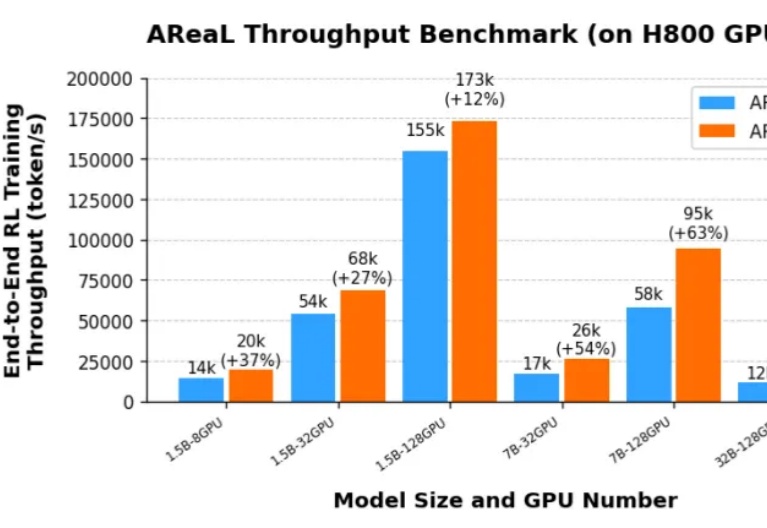

由于 DeepSeek R1 和 OpenAI o1 等推理模型(LRM,Large Reasoning Model)带来了新的 post-training scaling law,强化学习(RL,Reinforcement Learning)成为了大语言模型能力提升的新引擎。然而,针对大语言模型的大规模强化学习训练门槛一直很高:

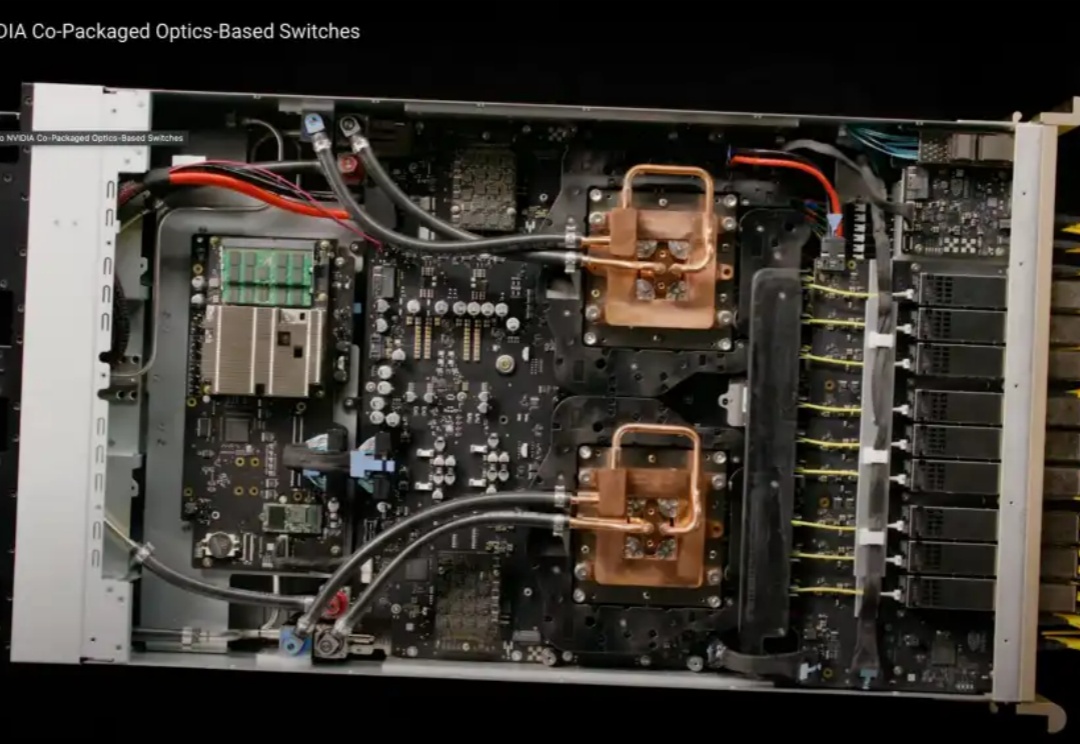

在GTC2025大会上,NVIDIA依旧延续着“算力的故事”。如果AI的发展依旧遵循着scaling law(规模定律),那么这个故事还能继续讲下去。

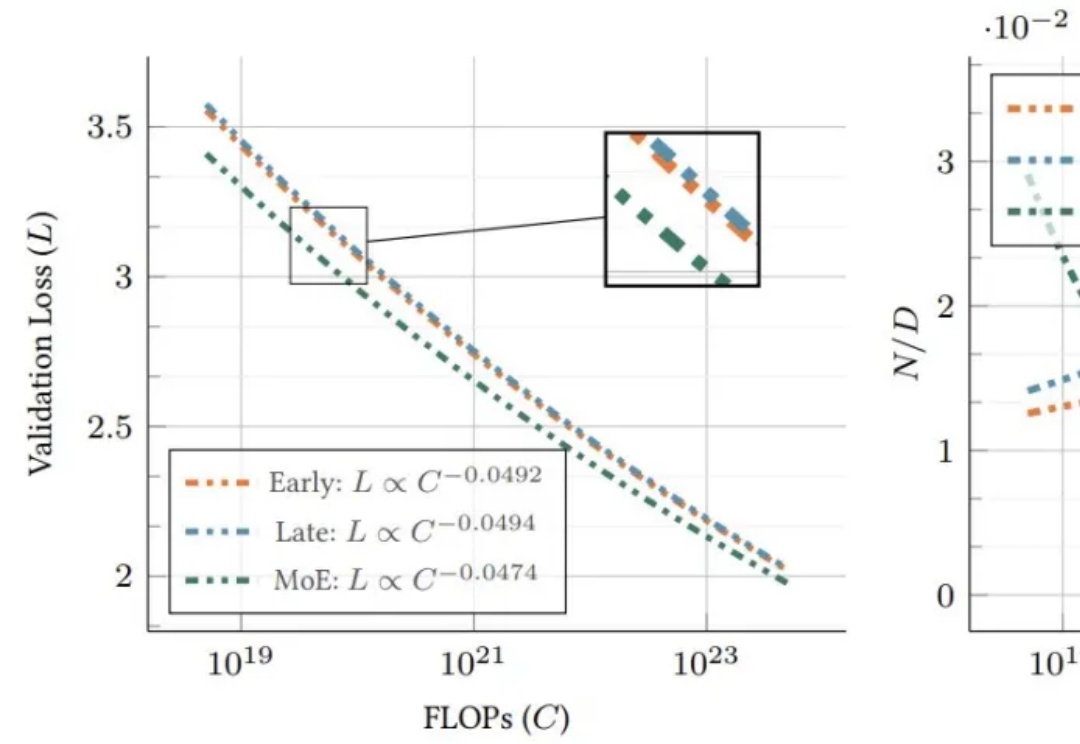

谷歌团队发现了全新Scaling Law!新方法DiLoCo被证明更好、更快、更强,可在多个数据中心训练越来越大的LLM。

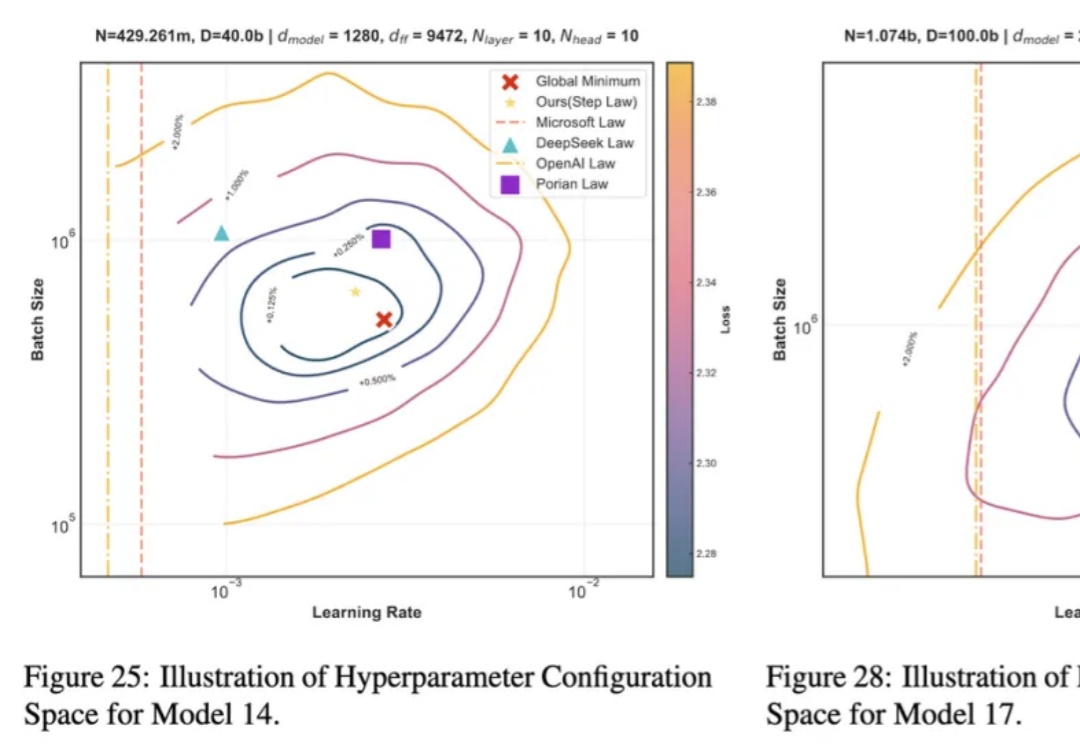

近年来,大语言模型 LLMs 在多种任务上的卓越表现已得到广泛认可。然而,要实现其高效部署,精细的超参数优化至关重要。为了探究最佳超参数的规律,我们开展了大规模的实证研究,通过在不同配置上进行网格搜索,我们揭示了一套通用的最优超参数缩放定律(Optimal Hyperparameter Scaling Law)。

谷歌发布了1000亿文本-图像对数据集,是此前类似数据集的10倍,创下新纪录!基于新数据集,发现预训练Scaling Law,虽然对模型性能提升不明显,但对于小语种等其他指标提升明显。让ViT大佬翟晓华直呼新发现让人兴奋!